要点 ・日本の計算機技術を用いて開発した日本語能力に優れた大規模言語モデルを公開 ・スーパーコンピュータ「富岳」の性能を最大限に活用した分散並列学習を実現 ・AI基盤モデルを科学研究に活用する「AI for Science」など革新的な研究やビジネスにつながる

【概要】

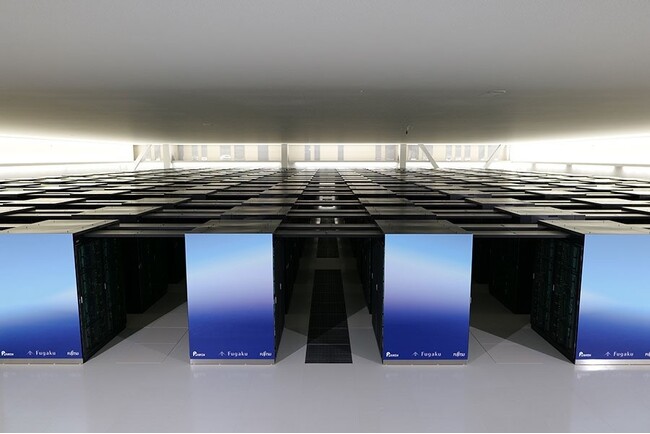

東京工業大学 学術国際情報センターの横田理央教授の研究チームと東北大学 大学院情報科学研究科の坂口慶祐准教授、富士通株式会社 人工知能研究所の白幡晃一シニアプロジェクトディレクター、理化学研究所 のMohamed Wahib(モハメド・ワヒブ)チームリーダー、名古屋大学 大学院工学研究科の西口浩司准教授、株式会社サイバーエージェント AI事業本部AI Labの佐々木翔大リサーチサイエンティスト、Kotoba Technologies Inc. の小島熙之CEOは、理化学研究所のスーパーコンピュータ「富岳」を用いて学習した日本語能力に優れた大規模言語モデル(注1)「Fugaku-LLM」を2024年5月10日に公開した。

今回、深層学習フレームワークを「富岳」に移植してTransformer(注2)の性能を「富岳」上で最適化するとともに、並列分散学習手法を開発し適用することで、「富岳」を用いて大規模言語モデルの学習を行う際の演算速度を6倍(参考文献1と比較)に高速化した。さらに、「富岳」向けにTofuインターコネクトD(注3)上での集団通信の最適化を行うことにより、通信速度を3倍(参考文献2と比較)高速化することに成功した。これにより「富岳」のCPUを用いて、現実的な時間内で大規模言語モデルを学習することが可能になった。

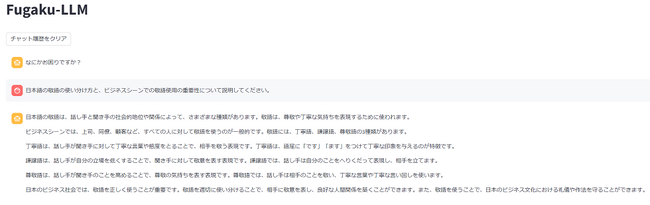

Fugaku-LLMは国内で多く開発されている70億パラメータ(注4)より一般に高性能、かつ現在の計算機環境下で扱いやすい130億パラメータのモデルとなっている。今回の学習では、サイバーエージェントが収集した独自の日本語学習データと英語のデータなどを用いているため、透明性と安全性を確保しつつ日本語性能にも優れている。国産かつ独自のデータで学習を行っているオープンなモデルの中では日本語ベンチマークJapanese MT-Bench(注5)で最高性能を達成し、特に人文社会系のタスクでは高いベンチマーク性能を発揮する。

Fugaku-LLMは、GitHub(注6)やHugging Face(注7)を通じ公開しており、ライセンスに従う限りにおいては、研究および商業目的での利用が可能である。

今後、多くの研究者や技術者が基盤モデルの改善や新たな応用研究に参画することで、さらに効率的な学習方法が創出され、科学シミュレーションと生成AIの連携や、数千のAIによるバーチャルコミュニティの社会シミュレーションなど、次世代の革新的な研究やビジネスでの応用につながることが期待される。

(公開リンク)

モデル:https://huggingface.co/Fugaku-LLM/Fugaku-LLM-13B

ソースコード:https://github.com/Fugaku-LLM/DeepSpeedFugaku

【背景】

近年、米国を中心に大規模言語モデル(LLM)の開発が活発に行われ、研究開発、経済社会、安全保障などあらゆる場面において大きな変革が起きている。米国以外の国々においても、自国でLLMを開発するために莫大な人的資源や計算資源を投入している。日本においても、AI研究のための計算資源として、日本のスーパーコンピュータのフラッグシップシステムである「富岳」に寄せられる期待は大きく、「富岳」における大規模な分散並列計算を実施するための環境整備が求められていた。

そこで、東京工業大学、東北大学、富士通、理化学研究所は、2023年5月より大規模言語モデルの共同研究開発を開始し、2023年8月からは、名古屋大学、サイバーエージェント、Kotoba Technologiesが参加した。

【各機関・企業の役割】

東京工業大学:全体総括、大規模言語モデルの並列化および通信の高速化(3種類の並列化を組み合わせた通信性能の最適化、TofuインターコネクトD上での集団通信の高速化)

東北大学:学習用データの収集、学習モデルの選択

富士通:演算高速化と通信高速化(TofuインターコネクトD上での集団通信の高速化、パイプライン並列の性能最適化)、事前学習と学習後のファインチューニング

理化学研究所:大規模言語モデルの分散並列化・通信の高速化(TofuインターコネクトD上での集団通信の高速化)

名古屋大学:3D形状生成AIへのFugaku-LLMの応用方法の検討

サイバーエージェント:学習用データの提供

Kotoba Technologies:深層学習フレームワークの「富岳」への移植

【研究成果】

1. 「富岳」における大規模言語モデル学習の計算性能を大幅に向上

本研究では、「富岳」を用いることで、大規模言語モデルを学習する際の演算速度を既存技術の6倍、通信速度を3倍に高速化することに成功した。演算高速化についてはTransformerの性能を「富岳」上で最適化するため、深層学習フレームワークMegatron-DeepSpeedを「富岳」へ移植、密行列積ライブラリのTransformer向け高速化を行った。通信高速化については3種類の並列化を組み合わせた「富岳」向け通信性能最適化とTofuインターコネクトD上での集団通信の高速化を行った。

通常、大規模言語モデルの学習にはGPU(注8)が用いられるが、大規模言語モデルの学習のために世界中でGPU不足が起きており、最新のGPUを大量に入手することは困難となっている。そのような中、GPUではなく富士通製の国産CPUを中央演算処理装置とした「富岳」を用いて大規模言語モデルを学習できたことは、日本の半導体技術の活用や、経済安全保障の観点からも重要な成果である。

また、今回の取り組みで得られた知見は「富岳」の後の次世代計算基盤の設計に活かされうるものであり、AI分野における日本の優位性確立に寄与していく。

2. 透明性と安全性を担保し、使いやすく日本語性能に優れた130億パラメータの大規模言語モデル

2023年には国内の企業で多くの大規模言語モデルが開発されたが、その多くは70億パラメータのモデルとなっている。大規模言語モデルは一般にパラメータ数が増えるに従ってその性能も向上するため、今回開発した130億パラメータのFugaku-LLMは高性能なモデルと言える。国外ではさらに大規模なモデルも開発されているが、大規模な言語モデルでは、使用する際にも大規模な計算資源が必要になるため、あまりにもパラメータ数が大きいものは使用しにくい。2024年現在の計算機環境と照らし合わせ、Fugaku-LLMでは高性能かつバランスの取れた130億パラメータとした。

また、日本語が扱える多くのモデルは、国外で開発されたオープンなモデルに対してさらに日本語データを学習させる継続学習(注9)の方法を採っている。それに対し、今回開発したFugaku-LLMは一から独自のデータを用い学習を行っているため、学習の全学習工程を把握でき、透明性と安全性の観点から優れている。

「富岳」の13,824台の計算ノードを用いて、約4,000億トークンを学習したが、学習データの約60%が日本語コンテンツであり、その他英語、数学、コードと組み合わせて学習した。他言語での学習をベースに日本語を継続学習するのではなく、元から多くの情報を日本語で学習したFugaku-LLMは、Japanese MT-Benchで平均スコア5.5と、国産で独自のデータで学習を行っているオープンなモデルの中では最高性能を達成した。特に人文社会系のタスクでは9.18と高いベンチマーク性能を発揮しており、敬語など日本語の特徴を踏まえた自然な対話を行えることなどが期待される。

【今後の展開】

研究者やエンジニアが大規模言語モデルの開発に活用できるよう、今回の取り組みで得られた研究成果をGitHubやHugging Faceを通じ公開している。ライセンスで定めた条件下で、誰もが研究および商業目的での利用が可能である。さらに、富士通はFugaku-LLMを、富士通の先端技術を無償で試せる「Fujitsu Research Portal」を通じて2024年5月10日より提供開始する。

公開されたモデルを用い、多くの研究者や技術者が基盤モデルの改善や新たな応用研究に参画することで、効率的な学習方法や言語モデルが創出され、科学シミュレーションと生成AIの連携による科学研究サイクルの自動化のようにAI基盤モデルを科学研究に活用する「AI for Science」、数千を超すAIによるバーチャルコミュニティの社会シミュレーションなど、次世代の革新的な研究やビジネスの成果につながることが期待される。

【付記】

本成果は、「富岳」政策対応課題「『富岳』を活用した大規模言語モデル分散並列学習手法の開発」(課題番号:hp230254)によるものである。

【用語説明】

注1

大規模言語モデル:

テキストの現れやすさをモデル化したもので、与えられた文脈(問いかけ)に対して続くテキスト(応答)を予測できる。

注2

Transformer:

単語の系列などを変換するためのニューラルネットワークで、現在の大規模言語モデルでは最も多く用いられている。2017年6月にGoogleが発表した「Attention Is All You Need」という論文で登場した深層学習モデルであり、主に自然言語処理の分野で使用される。

注3

TofuインターコネクトD:

「富岳」のノード間接続に用いられる6次元トーラスのトポロジーを持つ高速なネットワーク。Tofuとは、Torus fusionを短縮した名称であり、記号「D」は、高密度(High-density)を意味する。

注4

パラメータ:

大規模言語モデルなどのニューラルネットワークの規模を表す指標の一つ。パラメータが多いほど高性能なモデルになるが、学習にはその分多くのデータが必要になる。

注5

Japanese MT-Bench:

Stability AI社が提供している日本語のベンチマークテスト

注6

GitHub:

世界中でオープンソースソフトウェアの公開に使われているプラットフォーム。https://github.com/

注7

Hugging Face:

世界中でオープンソースソフトウェアの公開に使われているプラットフォーム。https://huggingface.co/

注8

GPU:

元々は描画のための演算加速器として生産されていたが、近年では深層学習の高速化に用いられている。

注9

継続学習:

すでに学習されている大規模言語モデルに対し、追加で学習を行う手法。異なる言語やドメインで言語モデルを活用するときに用いられる。

【参考文献】

1.COOL Chips 27(2024年4月17日~19日)発表「Implementation of Batch Matrix Multiplication for Large Language Model Training on A64FX CPUs」

2.第193回HPC研究発表会(2024年3月18日~19日)発表「富岳上の大規模機械学習におけるAll-reduce通信の高速化」

【本件に関するお問い合わせ】

東京工業大学

学術国際情報センター 教授

横田 理央

E-mail:rioyokota@gsic.titech.ac.jp

TEL: 03-5734-2121

FAX: 03-5734-3276

東北大学

大学院情報科学研究科 准教授

坂口 慶祐

E-mail:keisuke.sakaguchi@tohoku.ac.jp

TEL: 022-795-7091

富士通株式会社

富士通コンタクトライン(総合窓口)

0120-933-200(通話無料)

受付時間: 9時~12時および13時~17時30分(土曜日・日曜日・祝日・富士通指定の休業日を除く)

お問い合わせフォーム(https://contactline.jp.fujitsu.com/customform/csque04802/873532/)

理化学研究所

神戸事業所計算科学研究推進室

E-mail:r-ccs-koho@ml.riken.jp

名古屋大学

大学院工学研究科 准教授

西口 浩司

E-mail:koji.nishiguchi@gmail.com

TEL: 052-789-2736

Kotoba Technologies, Inc.

代表取締役

小島 熙之

E-mail:nkojima@kotoba.tech

プレスリリースに記載された製品の価格、仕様、サービス内容などは発表日現在のものです。その後予告なしに変更されることがあります。あらかじめご了承ください。

この銘柄の最新ニュース

富士通のニュース一覧- [PTS]ナイトタイムセッション17時時点 上昇52銘柄・下落52銘柄(通常取引終値比) 2024/05/20

- 日経平均寄与度ランキング(大引け)~日経平均は反発、信越化とファーストリテの2銘柄で約74円押し上げ 2024/05/20

- 日経平均寄与度ランキング(前引け)~日経平均は大幅反発、ファーストリテと信越化の2銘柄で約126円押し上げ 2024/05/20

- ADR日本株ランキング~AGCなど全般売り優勢、シカゴは大阪比比5円高の38745円~ 2024/05/20

- 信用残ランキング【売り残減少】 日産自、東電HD、三菱重 2024/05/19

マーケットニュース

富士通の取引履歴を振り返りませんか?

富士通の株を取引したことがありますか?みんかぶアセットプランナーに取引口座を連携すると売買履歴をチャート上にプロットし、自分の取引を視覚的に確認することができます。

アセットプランナーの取引履歴機能とは

※アセプラを初めてご利用の場合は会員登録からお手続き下さい。